Senin, 15 September 2025, saya mendapat kesempatan berharga untuk hadir di Universitas Kristen Maranatha, Bandung, memenuhi undangan dari Program Sarjana Teknik Elektro. Acara ini berupa kuliah umum dengan topik yang sedang hangat diperbincangkan dalam dunia teknologi: Quantum Computing.

Dr. Heri Andrianto, S.T., M.T., Ka Prodi Teknik Elektro menyampaikan kenang-kenangan.

Sejak awal, atmosfer ruang kuliah terasa penuh antusiasme. Mahasiswa dan dosen yang hadir mayoritas belum pernah bersentuhan langsung dengan konsep komputasi kuantum, namun rasa ingin tahu mereka begitu nyata. Inilah yang membuat saya semakin bersemangat menyampaikan materi—karena tidak ada yang lebih menyenangkan daripada menjelaskan sesuatu yang kompleks, lalu melihat wajah-wajah yang mulai “menangkap” esensinya.

Dalam kuliah tersebut, saya mengawali dengan sebuah ice breaker sederhana, membandingkan dunia komputasi klasik dengan dunia kuantum. Dari konsep dasar bit versus qubit, mahasiswa diajak masuk ke dunia yang mungkin awalnya terasa asing: keadaan superposisi, prinsip probabilistik, hingga bagaimana sebuah qubit fisik dibangun dari teknologi nyata seperti superkonduktor atau ion terperangkap.

Penjelasan tidak berhenti pada teori. Saya juga menampilkan beberapa ilustrasi visual—misalnya representasi qubit di Bloch sphere—dan memperlihatkan cuplikan kode sederhana. Dengan cara ini, mahasiswa tidak hanya mendapatkan gambaran abstrak, tetapi juga melihat bagaimana teori kuantum dapat diimplementasikan dalam bentuk simulasi komputasi nyata.

Selain membahas dasar-dasarnya, saya juga mengajak audiens untuk membayangkan potensi aplikasi. Quantum computing tidak hanya relevan untuk bidang teknik elektro, tetapi juga menyentuh ranah lain: optimasi sistem, keamanan informasi dengan kriptografi kuantum, pemodelan material baru, hingga percepatan riset di bidang farmasi. Harapannya, wawasan ini dapat menumbuhkan kesadaran bahwa perkembangan teknologi kuantum akan memiliki implikasi lintas disiplin, termasuk bagi mahasiswa elektro yang kelak berkarya di industri.

Menutup sesi, saya menekankan bahwa quantum computing bukanlah sesuatu yang perlu ditakuti karena kerumitannya, melainkan sebuah kesempatan untuk terus belajar. Sama seperti revolusi digital yang dulu mengubah pola hidup dan pekerjaan, revolusi kuantum sedang mengetuk pintu. Dan generasi muda, termasuk para mahasiswa yang saya temui hari itu, memiliki peran penting dalam menyambutnya.

Kuliah umum ini bagi saya bukan hanya sebuah kegiatan akademik, tetapi juga pengalaman yang mengingatkan kembali betapa pentingnya membangun jembatan antara pengetahuan frontier dengan dunia pendidikan tinggi di Indonesia. Semoga benih rasa ingin tahu yang tumbuh hari itu bisa terus berkembang, menjadi motivasi untuk eksplorasi lebih jauh dalam dunia riset maupun inovasi teknologi.

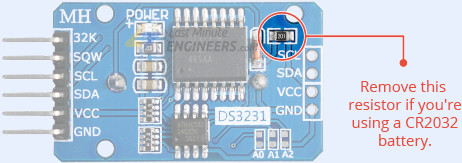

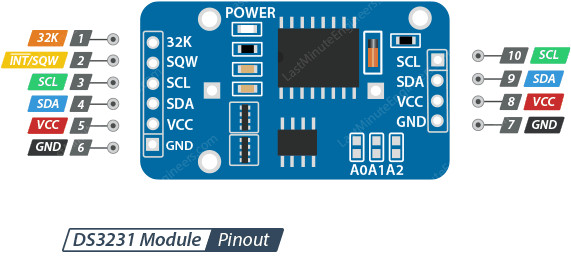

Pin SQW pada modul DS3231 menggunakan konfigurasi open-drain, sehingga memerlukan resistor pull-up agar dapat menghasilkan level logika yang benar. Resistor pull-up dengan nilai sekitar 4,7 kΩ hingga 10 kΩ dihubungkan antara pin SQW dan VCC (baik 3,3 V maupun 5 V) untuk memastikan sinyal square wave dapat berfungsi dengan stabil dan dapat dibaca dengan baik oleh sistem.

Pin SQW pada modul DS3231 menggunakan konfigurasi open-drain, sehingga memerlukan resistor pull-up agar dapat menghasilkan level logika yang benar. Resistor pull-up dengan nilai sekitar 4,7 kΩ hingga 10 kΩ dihubungkan antara pin SQW dan VCC (baik 3,3 V maupun 5 V) untuk memastikan sinyal square wave dapat berfungsi dengan stabil dan dapat dibaca dengan baik oleh sistem.